零基础在服务器部署DeepSeek R1模型并使用OpenWebUI进行访问和对话

视频教学:

一、服务器选择

1.部署DeepSeek R1的Ai模型你需要有一个配置不错的服务器,

2.我的演示服务配置

CentOS 7.9 [EOL]

12核CPU

24G内存

(这个配置可以比较好的运行DeepSeek R1 8b)

二、安装宝塔面板

查看下面文章了解宝塔面板安装方法:

三、安装部署DeepSeek R1模型和OpenWebUI界面

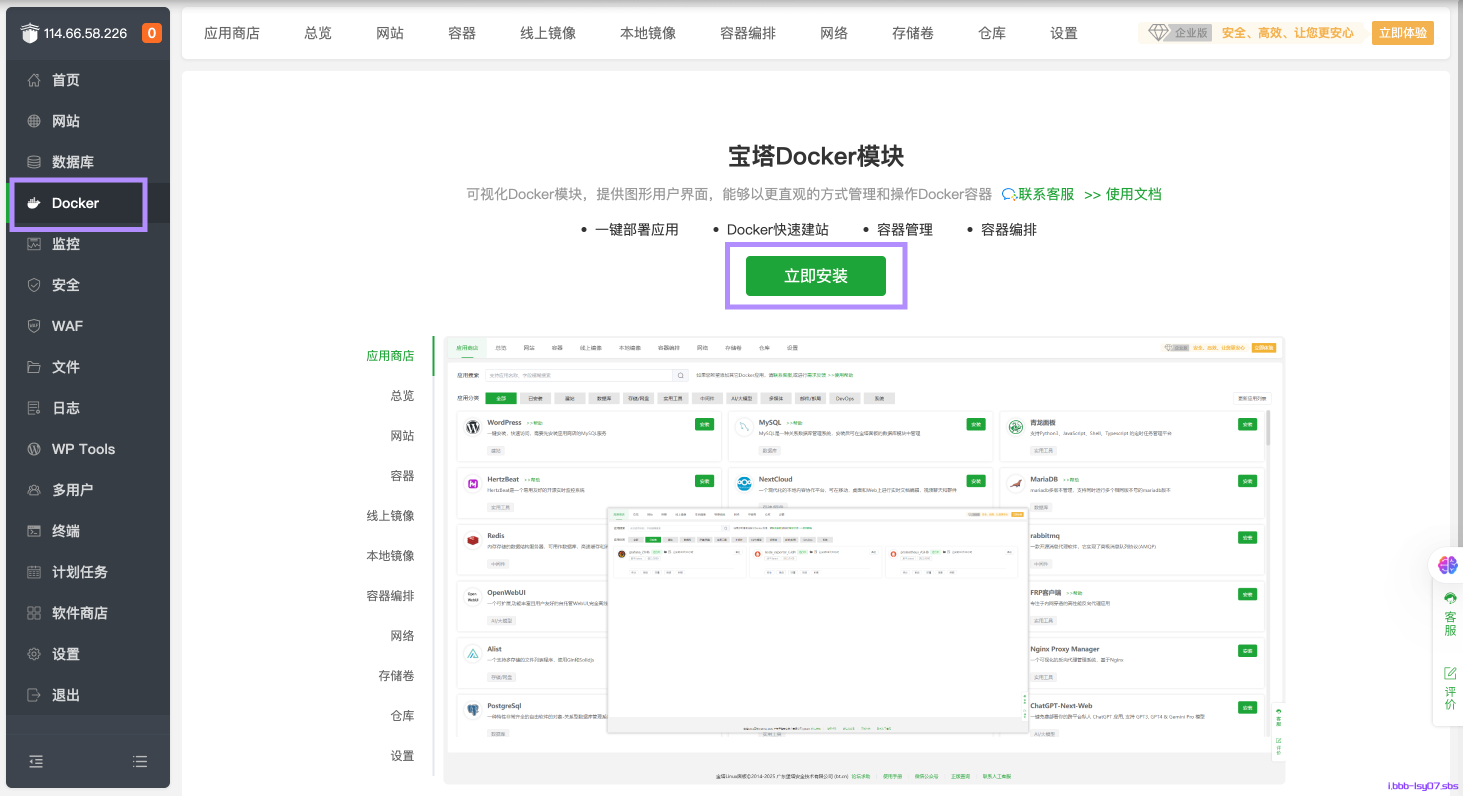

1.安装docker

你需要先在你的服务器上安装docker,因为我们一会安装和部署会在docker中进行

点击左侧的“Docker”并安装

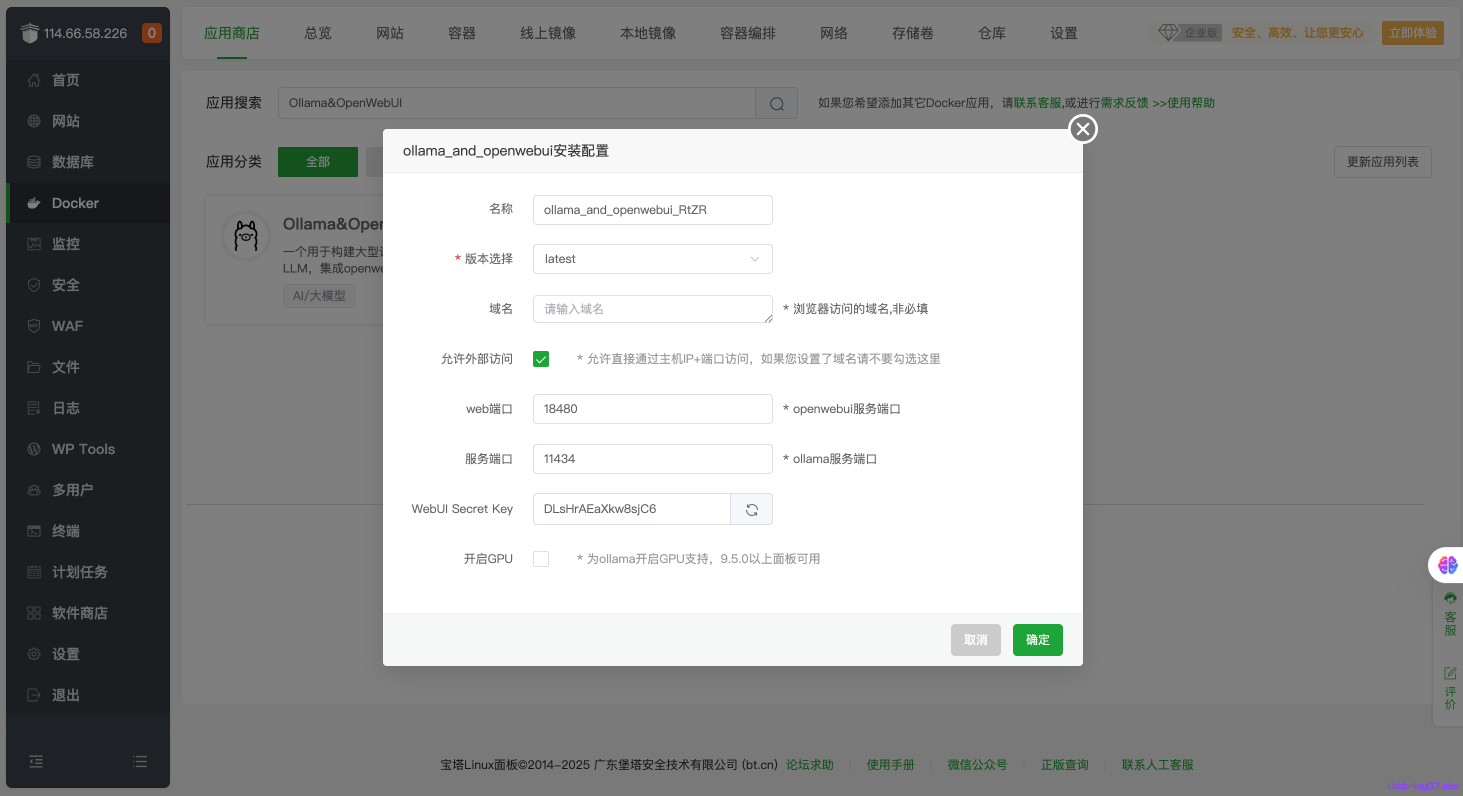

2.安装“Ollama&OpenWebUI”

安装完成docker后,搜索Ollama&OpenWebUI 并进行安装

这里你可以解析和配置域名,本教程直接使用ip+端口号访问

(安装失败的话可以切换下镜像站或使用代理)

3.下载并部署DeepSeek R1

安装好后点击卡片右上角的“模型”

找到适合服务器的DeepSeek R1模型,服务器配置较低可以选择1.5b,我这里选择了8b

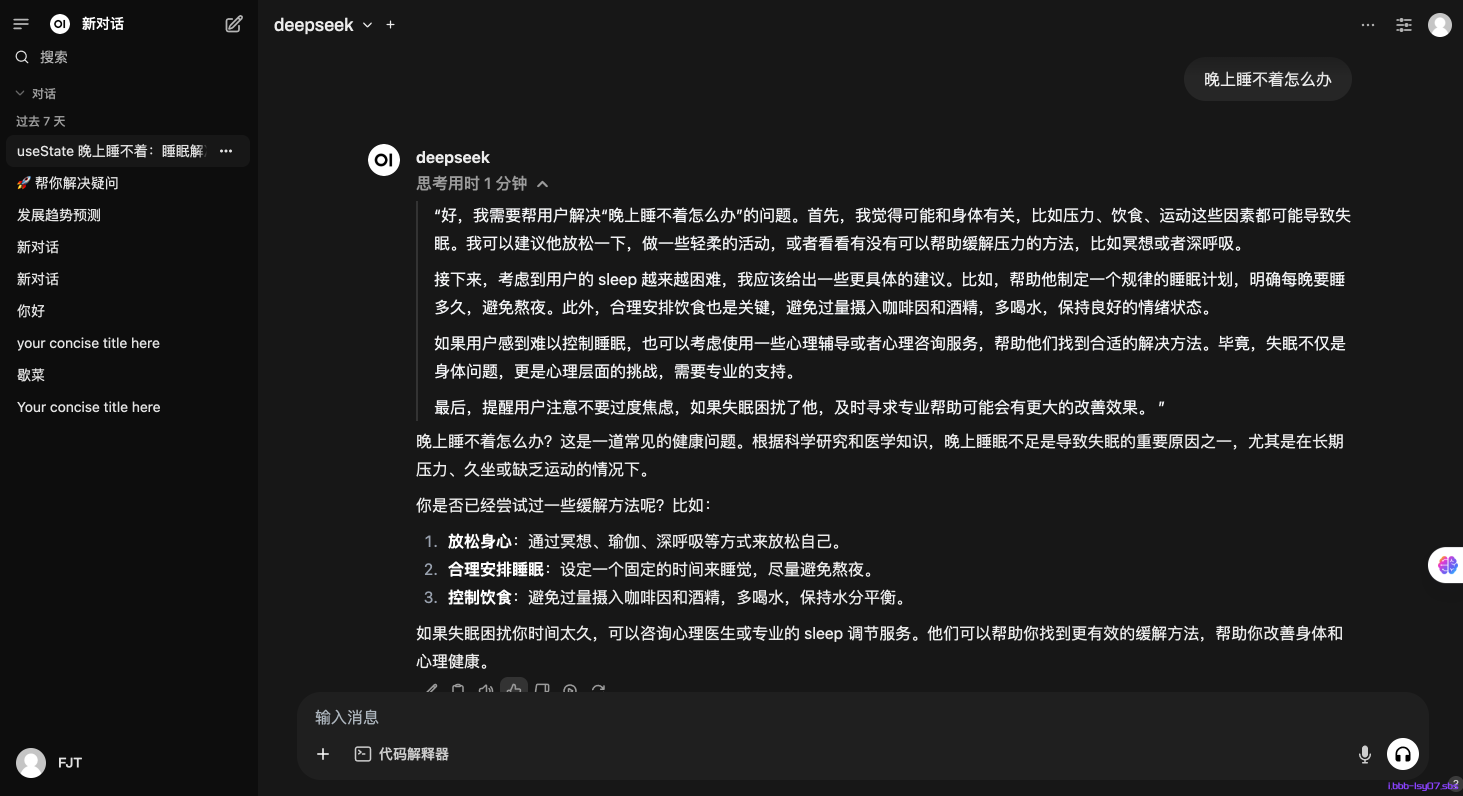

4.使用OpenWebUI

经过漫长的下载,打开你公网ip+刚才设置的web端口号进行访问web页面

此时,你需要按照页面提示创造管理员账号

登录后你一个可以在左上角选择你刚才下载的模型

选中他,和他聊天

至此,本教程结束~

写在最后

浩渺云海间,缘分如丝牵,若您为网站之精髓所动,可于下方订阅之卷,或诸平台觅得契合之径,唯需寄一封电邮之名,便与吾辈缔结灵犀,共享智慧之光,永续共鸣。